Définition:

L'informatique est le domaine d'activité scientifique, technique et industriel concernant letraitement automatique de l'information par des machines: des calculateurs, des systèmes embarqués, des ordinateurs, des robots, des automates, etc.

Le terme « informatique » vient des deux mots information et automatique ; il désigne à l'origine l'ensemble des activités liées à la conception et à l'emploi des ordinateurs, d'un point de vue principalement technique. Dans le vocabulaire universitaire américain, il désigne surtout l'informatique théorique : un ensemble de sciences formelles qui ont pour objet d'étude la notion d'information et des procédés de traitement automatique de celle-ci, l'algorithmique, parfois aussi le traitement du signal, la calculabilité ou la théorie de l'information. L'autre sens du mot (conception, déploiement et usage en entreprise) est désigné sous le nom de Data Processing.

« La science informatique n'est pas plus la science des ordinateurs que l'astronomie n'est celle des télescopes. »

— Michael R. Fellows et Ian Parberry

Apparu dans les années 1950, le secteur d'activité des technologies de l'information et de la communication est lié à la fois à l'informatique, l'électronique et la télécommunication. Les activités sont la production de matériel informatique - machines et pièces détachées, et de logiciels - procédés de traitement - qui sont destinés à l'acquisition, au stockage, à la transformation, la transmission et la restitution automatique d'informations. Le secteur fournit également de nombreux services liés à l'utilisation de ses produits :développement, maintenance, enseignement, assistance, surveillance et entretien.

*Histoire:

+Origines:

Depuis des millénaires, l'Homme a créé et utilisé des outils l'aidant à calculer (abaque, boulier...). Parmi les algorithmes les plus anciens, on compte des tables datant de l'époque d'Hammourabi (environ -1750).

En 1642, Blaise Pascal inventa la machine à calculer, la Pascaline, qui fut commercialisée et dont sept exemplaires existent dans des musées comme celui des arts et métiers et dont deux sont dans des collections privées (IBM en possède une).

Cependant, il faudra attendre la définition du concept de programmation (illustrée en premier par Joseph Marie Jacquard avec ses métiers à tisser à cartes perforées, suivi de Boole et Ada Lovelace pour ce qui est d'une théorie de la programmation des opérations mathématiques) pour disposer d'une base permettant d'enchaîner des opérations élémentaires de manière automatique.

+Mécanographie:

Une autre phase importante fut celle de la mécanographie. Dans les années 1880, Herman Hollerith, futur fondateur d'IBM invente une machine électromécanique destinée à faciliter le recensement en stockant les informations sur une carte perforée. Les trieuses et les tabulatrices furent utilisées à grande échelle pour la première fois par les Américains lors du recensement de 1890 aux États-Unis, suite à l'afflux des immigrants dans ce pays dans la seconde moitié du xixe siècle.

La première entreprise européenne qui a développé et commercialisé des équipements mécanographiques a été créée par l'ingénieur norvégien Fredrik Rosing Bull dans les années 1930 qui s'est installé en Suisse, avant de venir en France pour s'attaquer au marché français des équipements mécanographiques. Pendant la Seconde Guerre mondiale, René Carmille utilisait des machines mécanographiques Bull.

Les Allemands étaient équipés de machines mécanographiques déjà avant la Seconde Guerre mondiale. Ces équipements étaient installés par ateliers composés de trieuses, interclasseuses, perforatrices, tabulatrices et calculatrices connectées à des perforateurs de cartes. Les traitements étaient exécutés à partir de techniques électromécaniques utilisant aussi des lampes radio comme les triodes. La chaleur dégagée par ces lampes attirait les insectes, et les bugs (terme anglais pour insectes, parfois francisé en bogue) étaient une cause de panne courante. Ce n'est que suite à l'invention du transistor en 1947 et son industrialisation dans les années 1960, que l'informatique moderne a pu émerger.

+Informatique moderne:

L'ère de l'informatique moderne commença après la Seconde Guerre mondiale, avec l'invention du transistor, puis du circuit intégré quelques années plus tard. L'utilisation de ces composants électroniques à la place des relais électromécaniques et de tubes à videont permis de rendre les appareils à la fois plus petits, plus complexes, plus économiques et plus fiables.

Au même moment, le mathématicien Alan Turing théorise le premier ce qu'est un ordinateur, avec son concept de machine universelle de Turing.

Le domaine de l'informatique est donc un domaine récent, basé sur des sciences originaires de l'Antiquité (la cryptographie) et des expériences menées au xviie siècle, comme par exemple la machine à calculer de Blaise Pascal. Ce n'est qu'à la fin de la Seconde Guerre mondiale que l'informatique a été reconnue comme un domaine scientifique et technologique à part entière.

La série de livres The Art of Computer Programming de Donald Knuth, sortie à partir des années 1960, fait ressortir les aspects mathématiques de la programmation informatique. Edsger Dijkstra; Niklaus Wirth et Christopher Strachey travaillent et publient dans le même sens.

La miniaturisation des composants et la réduction des coûts de production, associées à un besoin de plus en plus pressant de traitement des informations de toutes sortes (scientifiques, financières, commerciales, etc.) a entraîné une diffusion de l'informatique dans toutes les couches de l'économie comme de la vie de tous les jours.

Des études en psychologie cognitive et en ergonomie réalisées dans les années 1970 par Xerox ont amené les outils informatiques à être équipés d'interfaces graphiques en vue de simplifier leur utilisation.

La démocratisation de l'utilisation d'Internet - réseau basé sur ARPANET - depuis 1995, a amené les outils informatiques à être de plus en plus utilisés dans une logique de réseau comme moyen de télécommunication, à la place des outils tels que la poste ou le téléphone. Elle s'est poursuivie avec l'apparition des logiciels libres puis des réseaux sociaux et des outils de travail collaboratif (dont Wikipédia n'est qu'un des nombreux exemples).

En France, l'informatique n'a commencé à vraiment se développer que dans les années 1960, avec le Plan Calcul. Depuis lors, les gouvernements successifs ont mené des politiques diverses en faveur de la Recherche scientifique, l'Enseignement, la tutelle des Télécommunications, la nationalisation d'entreprises clés.

*Science informatique:

La science informatique est une science formelle, dont l'objet d'étude est le calcul au sens large, c'est-à-dire non pas exclusivement arithmétique, mais en rapport avec tout type d'information que l'on peut représenter de manière symbolique par une suite de nombres. Ainsi, par exemple, textes, séquences d'ADN, images, sons ou formules logiques peuvent faire l'objet de calculs. Selon le contexte, on parle d'un calcul, d'un algorithme, d'un programme, d'une procédure, etc.

+Calculabilité:

Un algorithme est une manière systématique de procéder pour arriver à calculer un résultat. Un des exemples classiques est l'algorithme d'Euclide du calcul du « Plus grand commun diviseur » (PGCD) qui remonte au moins à 300 ans av. J.-C.

Mais il s'agit déjà d'un calcul complexe ; encore avant cela, le simple fait d'utiliser un abaque demande d'avoir réfléchi à un moyen systématique (et correct) d'utiliser cet abaque pour réaliser des opérations arithmétiques.

Mais il s'agit déjà d'un calcul complexe ; encore avant cela, le simple fait d'utiliser un abaque demande d'avoir réfléchi à un moyen systématique (et correct) d'utiliser cet abaque pour réaliser des opérations arithmétiques.

Des algorithmes existent donc depuis l'Antiquité, mais ce n'est que depuis les années 1930, avec les débuts de la théorie de la calculabilité, que les scientifiques se sont posé les questions « qu'est-ce qu'un modèle de calcul ? » et « est-ce que tout est calculable ? » et ont tenté d'y répondre formellement.

Il existe de nombreux modèles de calcul, mais les deux principaux sont la « machine de Turing » et le « lambda calcul ». Ces deux systèmes formels définissent des objets qui peuvent représenter ce qu'on appelle des procédures de calcul, des algorithmes ou des programmes. Ils définissent ensuite un moyen systématique d'appliquer ces procédures, c'est-à-dire de calculer.

Le résultat le plus important de la calculabilité est probablement la thèse de Church, qui postule que tous les modèles de calcul ont la même puissance. C'est-à-dire qu'il n'existe pas de procédure que l'on pourrait exprimer dans un modèle mais pas dans un autre.

Un deuxième résultat fondamental est l'existence de fonctions incalculables, une fonction étant ce que calcule une procédure ou un algorithme (ceux-ci désignant plutôt comment faire le calcul). On peut montrer qu'il existe des fonctions, bien définies, pour lesquelles il n'existe pas de procédure pour les calculer. L'exemple le plus connu étant probablement le problème de l'arrêt, qui montre qu'il n'existe pas de machine de Turing calculant si une autre machine de Turing donnée s'arrêtera (et donc donnera un résultat) ou non. Selon la thèse de Church-Turing, tous les modèles de calcul sont équivalents, par conséquent ce résultat s'applique aussi aux autres modèles, ce qui inclut les programmes et logiciels que l'on peut trouver dans les ordinateurs courants. À noter qu'il existe un lien très fort entre les fonctions que l'on ne peut pas calculer et les problèmes que l'on ne peut pas décide.

+Algorithmique:

L'algorithmique est l'étude comparative des différents algorithmes. Tous les algorithmes ne se valent pas : le nombre d'opérations nécessaires pour arriver à un même résultat diffère d'un algorithme à l'autre. Ce nombre d'opération, appelé la complexité algorithmique est le sujet de la théorie de la complexité des algorithmes, qui constitue une préoccupation essentielle en algorithmique.

La complexité algorithmique sert en particulier à déterminer comment le nombre d'opérations nécessaires évolue en fonction du nombre d'éléments à traiter (la taille des données) :

- soit l'évolution peut être indépendante de la taille des données, on parle alors de complexité constante ;

- soit le nombre d'opérations peut augmenter selon un rapport logarithmique, linéaire, polynomial ou exponentiel (dans l'ordre décroissant d'efficacité et pour ne citer que les plus répandues) ;

- une augmentation exponentielle de la complexité aboutit très rapidement à des durées de calcul déraisonnables pour une utilisation en pratique,

- tandis que pour une complexité polynomiale (ou meilleure), le résultat sera obtenu après une durée de calcul réduite, même avec de grandes quantités de données.

Nous arrivons maintenant à un problème ouvert fondamental en informatique : « P est-il égal à NP ? »

En simplifiant beaucoup : P est « l'ensemble des problèmes pour lesquels on connaît un algorithme efficace » et NP « l'ensemble des problèmes pour lesquels on connaît un algorithme efficace pour vérifier une solution à ce problème ».

Et en simplifiant encore plus : existe-t-il des problèmes difficiles ? Des problèmes pour lesquels il n'existe pas d'algorithme efficace.

Et en simplifiant encore plus : existe-t-il des problèmes difficiles ? Des problèmes pour lesquels il n'existe pas d'algorithme efficace.

Cette question est non seulement d'un grand intérêt théorique mais aussi pratique. En effet un grand nombre de problèmes courants et utiles sont des problèmes que l'on ne sait pas résoudre de manière efficace. C'est d'ailleurs un des problèmes du prix du millénaire et le Clay Mathematical Institute s'est engagé à verser un million de $ aux personnes qui en trouveraient la solution.

Comme nous venons de le dire : c'est un problème ouvert, donc formellement il n'y a pas de réponse reconnue. Mais, en pratique, la plupart des spécialistes s'accordent pour penser que P≠NP, c'est-à-dire qu'il existe effectivement des problèmes difficiles qui n'admettent pas d'algorithme efficace.

+Cryptologie:

Ce type de problème de complexité algorithmique est directement utilisé en cryptologie. En effet les méthodes de cryptologie modernes reposent sur l'existence d'une fonction facile à calculer qui possède une fonction réciproque difficile à calculer. C'est ce qui permet de chiffrer un message qui sera difficile à décrypter (sans la clé).

La plupart des chiffrements (méthode de cryptographie) reposent sur le fait que la procédure de Décomposition en produit de facteurs premiers n'a pas d'algorithme efficace connu. Si quelqu'un trouvait un tel algorithme il serait capable de décrypter la plupart des cryptogrammes facilement. On sait d'ailleurs qu'un calculateur quantique en serait capable, mais ce genre d'ordinateur n'existe pas, en tout cas pour le moment.

La plupart des chiffrements (méthode de cryptographie) reposent sur le fait que la procédure de Décomposition en produit de facteurs premiers n'a pas d'algorithme efficace connu. Si quelqu'un trouvait un tel algorithme il serait capable de décrypter la plupart des cryptogrammes facilement. On sait d'ailleurs qu'un calculateur quantique en serait capable, mais ce genre d'ordinateur n'existe pas, en tout cas pour le moment.

*Technologies de l'information et de la communication:

Le terme technologies de l'information et de la communication désigne un secteur d'activité et un ensemble de biens qui sont des applications pratiques des connaissances scientifiques en informatique ainsi qu'en électronique numérique, en télécommunication, ensciences de l'information et de la communication et en cryptologie.

- Le matériel informatique est un ensemble d'équipements (pièces détachées) servant au traitement des informations.

- Un logiciel contient des suites d'instructions qui décrivent en détail les algorithmes des opérations de traitement d'information ainsi que les informations relatives à ce traitement (valeurs clés, textes, images, etc.).

Le système de numération binaire est le système utilisé aujourd'hui dans tous les appareils en électronique numérique pour représenter l'information sous une forme qui peut être manipulée par des composants électroniques.

Les appareils informatiques sont équipés de quatre unités qui servent respectivement à entrer des informations, les stocker, les traiter puis les faire ressortir de l'appareil, selon les principes de la machine de Turing et l'architecture de von Neumann. Les informations circulent entre les pièces des différentes unités par des lignes de communication - les bus. Le processeur est la pièce centrale qui anime l'appareil en suivant les instructions des programmes qui sont enregistrés à l'intérieur.

+Appareils informatiques:

Il existe aujourd'hui une gamme étendue d'appareils capables de traiter automatiquement des informations.

De ces appareils, l’ordinateur est le plus connu, le plus ouvert, le plus complexe et un des plus anciens. L'ordinateur est une machine modulable et universelle qui peut être adaptée à de nombreuses tâches par ajout de matériel et/ou de logiciel.

Un système embarqué est un appareil équipé de matériel et de logiciel informatique, et dédié à une tâche bien précise. Ci-dessous quelques exemples :

- la console de jeu est un appareil destiné au jeu vidéo, une activité que l'on peut aussi exercer avec un ordinateur ;

- la calculatrice est le plus ancien appareil informatique, destiné à effectuer automatiquement des calculs mathématiques et scientifiques ;

- le NAS (acronyme de l'anglais network attached storage): un appareil destiné à stocker des informations, et les mettre à disposition via un réseau informatique ;

- le distributeur de billets: un automate qui distribue sur demande des billets de banque ou des tickets de transport public; les distributeurs sont souvent des ordinateurs déguisés ;

- le récepteur satellite: les émissions de télévision par satellite se font en numérique et sont captées et décodées par des appareils informatiques ;

- les appareils d’avionique sont des appareils électroniques et informatiques placés dans les avions et les véhicules spatiaux; ils servent à la navigation, la prévention des collisions et la télécommunication ;

- le GPS: un appareil qui affiche une carte géographique, et se positionne sur la carte grâce à un réseau de satellites; les cartes géographiques sont des informations créées par ordinateur ;

- le téléphone mobile : initialement simple appareil analogique, le téléphone portable a évolué, et il est maintenant possible de l'utiliser pour jouer, visionner des vidéos, des images; les smartphones sont des téléphones particulièrement évolués ;

- les systèmes d'arme sont des dispositifs informatiques qui permettent l'organisation et le suivi des opérations militaires : positionnement géographique, calcul des tirs, guidage des appareils et des véhicules ;

- les robots sont des appareils électromécaniques qui effectuent des tâches à la place des humains, de manière autonome; l'autonomie est assurée par un appareil informatique placé à l'intérieur ou à l'extérieur du robot.

+Matériel informatique:

Le matériel informatique (hardware en l'anglais) est l'ensemble des pièces "électroniques" nécessaires au fonctionnement des appareils informatiques. Les appareils comportent généralement un boîtier dans lequel se trouvent les pièces centrales (par exemple le processeur), et des pièces périphériques servant à l'acquisition, au stockage, à la restitution et la transmission d'informations. L'appareil est un assemblage de pièces qui peuvent être de différentes marques. Le respect des normes industrielles par les différents fabricants assure le fonctionnement de l'ensemble.

Le matériel informatique (hardware en l'anglais) est l'ensemble des pièces "électroniques" nécessaires au fonctionnement des appareils informatiques. Les appareils comportent généralement un boîtier dans lequel se trouvent les pièces centrales (par exemple le processeur), et des pièces périphériques servant à l'acquisition, au stockage, à la restitution et la transmission d'informations. L'appareil est un assemblage de pièces qui peuvent être de différentes marques. Le respect des normes industrielles par les différents fabricants assure le fonctionnement de l'ensemble.+Logiciel informatique:

Un logiciel est un ensemble d'informations relatives à un traitement automatisé qui correspond à la « procédure » d'une Machine de Turing, la mécanique de cette machine correspondant au processeur. Le logiciel peut être composé d'instructions et de données. Les instructions mettent en application les algorithmes en rapport avec le traitement d'information voulu. Les données incluses dans un logiciel sont les informations relatives à ce traitement ou exigées par lui (valeurs clés, textes, images, etc.).

Le logiciel peut prendre une forme exécutable (c'est-à-dire directement compréhensible par le micro-processeur) ou source, c'est-à-dire dont la représentation est composée d'une suite d'instructions directement compréhensible par un individu. Ainsi donc, on peut considérer le logiciel comme une abstraction qui peut prendre une multitude de formes: il peut être imprimé sur du papier, conservé sous forme d'un fichier fichiers informatiques ou encore stocké dans une mémoire (une disquette, une clé USB).

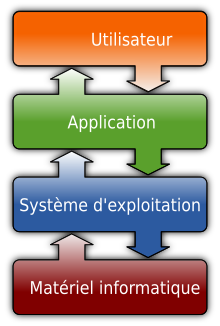

Un appareil informatique peut contenir de très nombreux logiciels, organisés en trois catégories :

- logiciel applicatif : un logiciel applicatif contient les instructions et les informations relatives à une activité automatisée. Un ordinateur peut stocker une panoplie de logiciels applicatifs, correspondant aux très nombreuses activités pour lesquelles il est utilisé ;

- logiciel système : un logiciel système contient les instructions et les informations relatives à des opérations de routine effectuées par les différents logiciels applicatifs ;

- système d'exploitation : le système d'exploitation est un logiciel système qui contient l'ensemble des instructions et des informations relatives à l’utilisation commune du matériel informatique par les logiciels applicatifs ;

- micrologiciel (firmware en anglais) : lors d'une utilisation d'un équipement matériel déterminé - lors d'une opération de routine. Un micrologiciel contient les instructions et les informations relatives au déroulement de cette opération sur l'équipement en question. Un appareil informatique peut contenir de nombreux micrologiciels. Chaque micrologiciel contient les instructions et les informations relatives à tous les traitements qui peuvent être effectués par les équipements d'une série ou d'une marque déterminée.

Un logiciel embarqué, un logiciel libre, un logiciel propriétaire font référence à une manière de distribuer le logiciel.

*Informatique et développement durable:

On applique souvent l'adjectif « virtuel » ou « immatériel » aux produits de l'informatique, ce qui pourrait laisser croire que l'informatique est peu consommatrice de ressources naturelles. Jean-Marc Jancovici montre que la dématérialisation, souvent présentée comme une solution pour le développement durable de l'économie, ne s'est pas accompagnée d'une diminution des flux physiques par rapport aux flux d'information. En pratique, dans les années 2010, les directions des systèmes d'information sont généralement tenues à l'écart des programmes de développement durable des entreprises.

On se rend compte aujourd'hui, avec les premières études des experts en informatique verte, que l'informatique serait directement à l'origine de 5 % des émissions de gaz à effet de serre de la France. L'informatique générerait également une forte consommation d'électricité.

L'application des principes de développement durable à l'informatique se décompose en plusieurs étapes principales. Très schématiquement :

- la première étape, désignée par informatique verte en France (le terme angloaméricain est Green IT 1.0) désigne l'ensemble des méthodes qui réduisent l'impact de l'informatique sur l'environnement par une démarche écoresponsable (écoconception, économies d'énergie, gestion des déchets). Elle s'applique principalement au matériel informatique, ainsi qu'aux méthodes de développement logiciel qui diminuent l'impact sur la consommation électrique ;

- la deuxième étape, désignée par écoinformatique (ou écoTIC, ou Green IT 2.0 en angloaméricain), désigne la réduction de l’empreinte écologique de la société grâce aux technologies de l'information et de la communication : c'est l'utilisation des TIC pour réorganiser et optimiser les processus métiers en fonction de leur empreinte écologique grâce l’analyse du cycle de vie (ACV). Elle analyse et échange des informations environnementales ;

- la troisième étape est celle des TIC durables, et englobe les trois piliers du développement durable (environnement, social, économique).

À terme, le développement durable devrait faire évoluer les modèles employés en informatique. Il est, en effet, nécessaire d'expliciter la sémantique des données, documents ou modèles, ce qui relève de la branche de l'informatique appelée représentation des connaissances. Plusieurs projets en écoinformatique se déroulent dans le cadre d'initiatives telles que le web sémantique

Yassin

(Texte adapté) Source:Wikipédia